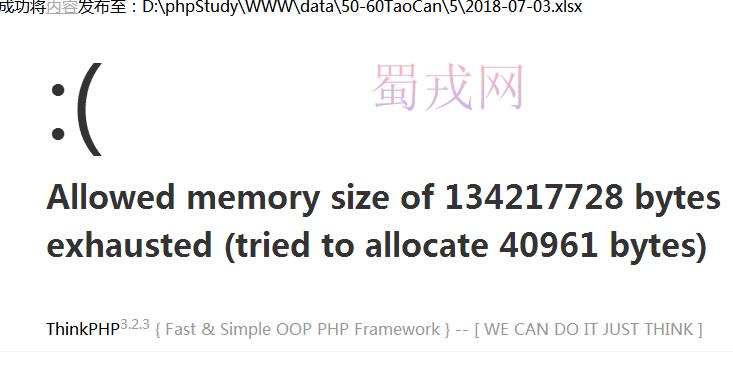

如果一次采集的数据量过多,超过1W条左右,集采完毕入库后最后出现这种情况。

建议:可不可以边采集边入库,不要一次都采完了再一起入库。

我亲身体验好几回,手动采集时,如果意外把页面关掉了,之前采集的都白采了,再采还要从头再来

如果变成边采集边入库,就不会出现这种情况,比如说我采集到第650条时,页面被意外关闭了。

那我再打开页面再采的时候,之前那650条已经入库了。会从第651条继续开始采,这样就不会出现重新开始的情况。

----------------------------------------------------

还有,再提个建议,

正在采集的实时状态,

把“采集内容页:http://"前面加上排序

比如说:

当前采集总页数为:16500页

正在集采第:

1、采集内容页:http://www.xxx.com

2、采集内容页:http://www.xxx.com

3、采集内容页:http://www.xxx.com

4、采集内容页:http://www.xxx.com

...........

16500、采集内容页:http://www.xxx.com

采集完毕。

谢谢反馈,这个问题在下个版本修复,暂时可以设置下php的memory_limit参数 下个版本什么时候出来呀,现在有好多问题呀,影响使用啊,甚至使用不了啊。

嗯,正在开发中,最晚7月底